Prevedere che sensazioni ci darà toccare un oggetto solo guardandolo è un’azione automatica nell’essere umano che accade spontaneamente ogni giorno, ma far accadere lo stesso fenomeno in un robot è tutt’altro che scontato. I ricercatori del Computer Science and Artificial Intelligence Lab (CSAIL) del MIT sono riusciti a sviluppare un nuovo sistema in grado di fornire ai robot questa capacità di collegare più sensi: grazie all’intelligenza artificiale, un braccio meccanico automatizzato e con il senso del tatto sarà in grado di generare rappresentazioni visive di oggetti a partire dai segnali tattili acquisiti e, per converso, anche di prevederne le qualità tattili da un certo numero di informazioni visive. Noi esseri umani questa abilità la diamo per scontata, dato che con uno sguardo riusciamo a riconoscere persone e oggetti e di conseguenza prevedere da una parte le sensazioni che daranno al tatto, e dall’altra quale sia la forza da utilizzare nell’afferrarli o toccarli. Il robot però non dispone di questa facoltà, e per insegnargliela i ricercatori hanno deciso di tentare l’approccio del machine learning.

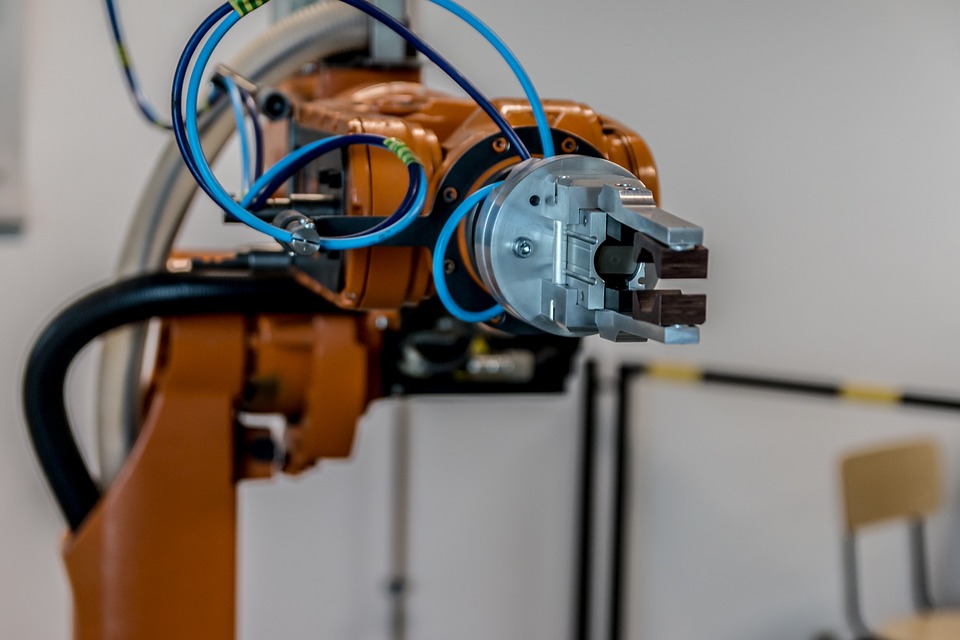

Il risultato è un braccio robotico che attraverso le immagini registrate dalle videocamere di bordo può capire in anticipo se sta andando a maneggiare uno strumento delicato o un robusto, e regolare la propria forza di conseguenza senza bisogno di essere programmato. Viceversa se privo di videocamera, può comunque riconoscere gli oggetti che sta toccando semplicemente sfiorandoli.

Il risultato è un braccio robotico che attraverso le immagini registrate dalle videocamere di bordo può capire in anticipo se sta andando a maneggiare uno strumento delicato o un robusto, e regolare la propria forza di conseguenza senza bisogno di essere programmato. Viceversa se privo di videocamera, può comunque riconoscere gli oggetti che sta toccando semplicemente sfiorandoli.  Il MIT ha precisato però che per il momento questo sistema funziona solo nell’ambiente controllato allestito dai ricercatori, il che vuol dire che non può inferire le proprietà di oggetti mai visti né toccati, ma neanche quelle di oggetti noti che però si discostano di troppo per aspetto o composizione da quelli presenti nella propria banca dati. Con il tempo, il braccio robot verrà arricchito di nuove informazioni e riuscirà anche ad imparare in autonomia

Il MIT ha precisato però che per il momento questo sistema funziona solo nell’ambiente controllato allestito dai ricercatori, il che vuol dire che non può inferire le proprietà di oggetti mai visti né toccati, ma neanche quelle di oggetti noti che però si discostano di troppo per aspetto o composizione da quelli presenti nella propria banca dati. Con il tempo, il braccio robot verrà arricchito di nuove informazioni e riuscirà anche ad imparare in autonomia Ti potrebbe interessare anche: Intelligenza artificiale: costruire un sistema di AI a livello umano che potrebbe cambiare il mondo

Ti potrebbe interessare anche: Intelligenza artificiale: costruire un sistema di AI a livello umano che potrebbe cambiare il mondo